高通相信,CloudAI100的性能优势可以让它在深度学习芯片市场上占据上风。高通有信心在产品性能、AI处理、数据处理等方面成为强大的领导者。

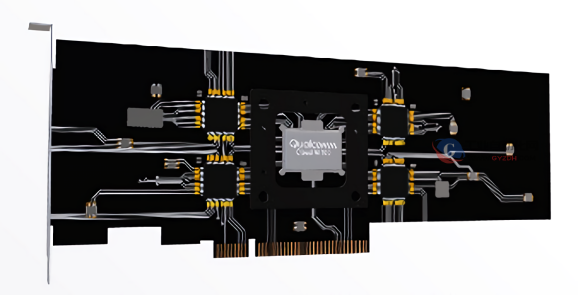

昨天,高通在旧金山召开了年度人工智能日(AIDay)大会。在本次会议上,该公司揭开了三款芯片的神秘面纱,而这三款芯片可以用于智能手机、平板电脑以及其他移动设备。然而,这些芯片只是开胃菜,重头戏是一款专为边缘计算设计的新产品——QualcommCloudAI100。

产品管理高级副总裁KeithKressin说,“我们设计这个全新的信号处理器旨在为AI推理服务,”他还补充道,产品将在明年下半年开始生产。

CloudAI100集成了一系列开发工具,包括编译器、调试器、分析器、监视器、芯片调试器和量化器。此外,它还支持包括ONNX、Glow和XLA在内的运行时,以及Google的TensorFlow,Facebook的PyTorch、Keras、MXNet,百度的PaddlePaddle和微软的CognitiveToolkit等机器学习框架。

高通估计,这款产品的峰值性能是骁龙855和骁龙820的3至50倍。公司还声称,与传统的FPGA相比,它在推理方面的平均速度要快10倍左右。此外,以TOPs(高性能芯片常用的性能指标)衡量,CloudAI100的运算速度可以“远远超过”100TOPs。相比之下,骁龙855的最快只有7TOPs。

Kressin解释说:“FPGA或GPU通常可以更有效地进行AI推理处理,因为GPU是并行的,而CPU是串行的,并行芯片更适合AI处理。不过,GPU最初是为处理图形而生,我们要专门设计一个芯片来加速AI,才能得到更加显著的提升。从CPU到FPGA或GPU,经过了一个数量级的改进,定制AI加速器能再加一个数量级改进。”

高通进军云计算领域之前,它的主要竞争对手华为发布了业界最高性能Arm架构处理器鲲鹏920。在SPECint(一个由12个程序组成的基准测试套件,旨在测试整数性能)中,该芯片的得分超过了930分,比行业基准高出将近25%,而功耗比行业现有厂商提供的产品低30%。

高通的竞争对手可不止华为一个。

今年1月,在拉斯维加斯举行的消费电子展上,英特尔详细介绍了即将推出的Nervana神经网络处理器(NNP-I)。据报道,该处理器的AI训练性能将达到竞争对手显卡的10倍。谷歌去年推出了专用推理芯片EdgeTPU。阿里巴巴去年12月宣布,计划在今年下半年推出首款自主研发的AI推理芯片。

在FPGA方面,亚马逊最近推出了自己的AI云加速芯片,名为AWSInferentia。微软也在ProjectBrainwave中展示了类似的产品。今年3月,Facebook发布了用于AI推理的服务器芯片KingsCanyon。本月,英特尔宣布推出Agilex系列芯片,优化AI和大数据工作。

但高通相信,CloudAI100的性能优势可以让它在深度学习芯片市场上占据上风。预计到2025年,该市场规模将达到6630万美元。

“很多公司都把网络硬件放在边缘,形成一个内容传输网络,这个网络可以完成云游戏或是AI处理等不同类型的任务。这个趋势非常关键。因为这样一来,无论是终端用户的输入技术,还是云端,都会有高通的参与。”

高通还有另一个潜在优势——生态系统的支持。

去年11月,高通承诺向一家专注于edgeAI和on-deviceAI的初创基金提供1亿美元,资金将用于自动驾驶汽车、机器人、计算机视觉和物联网等领域。去年5月,它与微软合作开发了一个visionAI工具包,辅助嵌入在系统芯片中的AI加速器。

“就市场规模而言,推理正在催生一个大型芯片市场,”Kressin表示,“随着时间的推移,我们预计,在2018年至2025年期间,市场规模大约会扩大10倍。我们非常有信心,高通在产品性能、AI处理、数据处理等方面,将会成为强大的领导者。”

客服热线:

客服热线:

津公网安备 12020202000164号

津公网安备 12020202000164号